-

GPU 한 대로 95배 빠르게 그래프 분석 AI 'FlexGNN' 개발

텍스트 기반 대규모 언어 모델(LLM)인 ChatGPT 등과 함께, 산업 현장에서는 금융 거래, 주식, SNS, 환자기록, 등 비정형 데이터를 그래프 형태로 분석하는 GNN(Graph Neural Network) 기반의 그래프 AI 모델이 적극 활용되고 있다. 하지만 전체 그래프를 한 번에 학습(풀 그래프 학습)하는데 막대한 메모리와 GPU 서버가 필요하다는 한계점이 있다. KAIST 연구진이 단 한 대의 GPU 서버만으로도 대규모 GNN 모델을 최고속 학습할 수 있는 세계 최고 성능의 소프트웨어 기술 개발에 성공했다.

우리 대학 전산학부 김민수 교수 연구팀이 여러 대의 GPU 서버를 활용하는 기존 방식과 달리 한 대의 GPU 서버에서 대규모 풀(full) 그래프 AI 모델을 빠르게 학습하고 추론할 수 있는 GNN 시스템 ‘FlexGNN(플렉스지엔엔)’을 개발했다고 13일 밝혔다. FlexGNN은 기존 기술 대비 학습 속도를 최대 95배 향상한다.

최근 기후, 금융, 의료, 제약, 제조, 유통 등 다양한 분야에서는 데이터를 정점과 간선으로 구성된 그래프 형태로 변환해 분석 및 예측하는 사례가 증가하고 있다.

전체 그래프를 모두 학습에 활용하는 풀 그래프 방식이 더욱 우수한 정확도를 보이지만, 학습 과정에서 대규모의 중간 데이터(intermediate data)가 발생해 메모리 부족 현상이 빈번히 발생하고, 여러 서버 간의 데이터 통신으로 인해 학습 시간이 길어지는 한계가 있었다.

연구팀이 개발한 FlexGNN은 이러한 문제를 극복하기 위해 여러 대의 GPU 서버 대신 단일 GPU 서버에서 SSD(솔리드 스테이트 드라이브)와 메인 메모리를 활용한 최적의 AI 모델 학습을 수행한다.

특히 데이터베이스 시스템의 질을 최적화시키는 AI 퀴리 최적화 학습을 통해 GPU-메인 메모리-SSD 계층 간 모델 파라미터, 학습 데이터, 중간 데이터를 최적의 시점과 방식으로 계산을 시키는 새로운 학습 최적화 기술을 개발했다.

이를 통해 FlexGNN은 데이터 크기, 모델 규모, GPU 메모리 등 가용 자원 상황에 따라 유연하게 최적의 학습 실행 계획을 생성해 높은 자원 효율성과 학습 속도를 구현한다.

그 결과, 메인 메모리 용량을 훨씬 초과하는 데이터에 대해서도 GNN 모델을 학습하며, 단일 GPU 서버에서도 최대 95배 빠르게 학습이 가능해졌다. 특히 기후 예측 등에서 슈퍼컴퓨터보다 정밀한 분석이 가능한 풀 그래프 AI 구현이 현실화됐다.

우리 대학 김민수 교수는 “날씨 예측과 신소재 발견 등 복잡한 문제를 해결하는데 풀 그래프 GNN 모델이 활발히 활용되면서 관련 기술의 중요성이 점점 높아지고 있다”며 “FlexGNN이 그동안 어려움으로 남아 있던 그래프 AI 모델의 학습 규모와 속도 문제를 획기적으로 해결한 만큼, 다양한 산업 분야에 널리 활용되기를 기대한다”고 밝혔다.

이번 연구는 전산학부 배정민 박사과정이 제1 저자로, 김민수 교수창업기업인 (주)그래파이의 한동형 CTO가 제2 저자로 참여했으며, 김 교수가 교신저자를 맡았다.

연구 결과는 세계적 권위의 데이터마이닝 학술대회인 ‘ACM KDD’에서 지난 8월 5일에 발표됐다. FlexGNN 기술은 향후 (주)그래파이의 그래프 DB 솔루션인 그래프온(GraphOn)에도 적용될 예정이다.

※ 논문제목: FlexGNN: A High-Performance, Large-Scale Full-Graph GNN System with Best-Effort Training Plan Optimization

※ DOI: https://doi.org/10.1145/3711896.3736964

한편, 이번 연구는 과기정통부 IITP SW스타랩과 IITP-ITRC, 그리고 한국연구재단 중견과제의 지원을 받아 수행됐다.

GPU 한 대로 95배 빠르게 그래프 분석 AI 'FlexGNN' 개발

텍스트 기반 대규모 언어 모델(LLM)인 ChatGPT 등과 함께, 산업 현장에서는 금융 거래, 주식, SNS, 환자기록, 등 비정형 데이터를 그래프 형태로 분석하는 GNN(Graph Neural Network) 기반의 그래프 AI 모델이 적극 활용되고 있다. 하지만 전체 그래프를 한 번에 학습(풀 그래프 학습)하는데 막대한 메모리와 GPU 서버가 필요하다는 한계점이 있다. KAIST 연구진이 단 한 대의 GPU 서버만으로도 대규모 GNN 모델을 최고속 학습할 수 있는 세계 최고 성능의 소프트웨어 기술 개발에 성공했다.

우리 대학 전산학부 김민수 교수 연구팀이 여러 대의 GPU 서버를 활용하는 기존 방식과 달리 한 대의 GPU 서버에서 대규모 풀(full) 그래프 AI 모델을 빠르게 학습하고 추론할 수 있는 GNN 시스템 ‘FlexGNN(플렉스지엔엔)’을 개발했다고 13일 밝혔다. FlexGNN은 기존 기술 대비 학습 속도를 최대 95배 향상한다.

최근 기후, 금융, 의료, 제약, 제조, 유통 등 다양한 분야에서는 데이터를 정점과 간선으로 구성된 그래프 형태로 변환해 분석 및 예측하는 사례가 증가하고 있다.

전체 그래프를 모두 학습에 활용하는 풀 그래프 방식이 더욱 우수한 정확도를 보이지만, 학습 과정에서 대규모의 중간 데이터(intermediate data)가 발생해 메모리 부족 현상이 빈번히 발생하고, 여러 서버 간의 데이터 통신으로 인해 학습 시간이 길어지는 한계가 있었다.

연구팀이 개발한 FlexGNN은 이러한 문제를 극복하기 위해 여러 대의 GPU 서버 대신 단일 GPU 서버에서 SSD(솔리드 스테이트 드라이브)와 메인 메모리를 활용한 최적의 AI 모델 학습을 수행한다.

특히 데이터베이스 시스템의 질을 최적화시키는 AI 퀴리 최적화 학습을 통해 GPU-메인 메모리-SSD 계층 간 모델 파라미터, 학습 데이터, 중간 데이터를 최적의 시점과 방식으로 계산을 시키는 새로운 학습 최적화 기술을 개발했다.

이를 통해 FlexGNN은 데이터 크기, 모델 규모, GPU 메모리 등 가용 자원 상황에 따라 유연하게 최적의 학습 실행 계획을 생성해 높은 자원 효율성과 학습 속도를 구현한다.

그 결과, 메인 메모리 용량을 훨씬 초과하는 데이터에 대해서도 GNN 모델을 학습하며, 단일 GPU 서버에서도 최대 95배 빠르게 학습이 가능해졌다. 특히 기후 예측 등에서 슈퍼컴퓨터보다 정밀한 분석이 가능한 풀 그래프 AI 구현이 현실화됐다.

우리 대학 김민수 교수는 “날씨 예측과 신소재 발견 등 복잡한 문제를 해결하는데 풀 그래프 GNN 모델이 활발히 활용되면서 관련 기술의 중요성이 점점 높아지고 있다”며 “FlexGNN이 그동안 어려움으로 남아 있던 그래프 AI 모델의 학습 규모와 속도 문제를 획기적으로 해결한 만큼, 다양한 산업 분야에 널리 활용되기를 기대한다”고 밝혔다.

이번 연구는 전산학부 배정민 박사과정이 제1 저자로, 김민수 교수창업기업인 (주)그래파이의 한동형 CTO가 제2 저자로 참여했으며, 김 교수가 교신저자를 맡았다.

연구 결과는 세계적 권위의 데이터마이닝 학술대회인 ‘ACM KDD’에서 지난 8월 5일에 발표됐다. FlexGNN 기술은 향후 (주)그래파이의 그래프 DB 솔루션인 그래프온(GraphOn)에도 적용될 예정이다.

※ 논문제목: FlexGNN: A High-Performance, Large-Scale Full-Graph GNN System with Best-Effort Training Plan Optimization

※ DOI: https://doi.org/10.1145/3711896.3736964

한편, 이번 연구는 과기정통부 IITP SW스타랩과 IITP-ITRC, 그리고 한국연구재단 중견과제의 지원을 받아 수행됐다.

2025.08.13

조회수 193

-

챗GPT 등 대형 AI모델 학습 최적화 시뮬레이션 개발

최근 챗GPT, 딥시크(DeepSeek) 등 초거대 인공지능(AI) 모델이 다양한 분야에서 활용되며 주목받고 있다. 이러한 대형 언어 모델은 수만 개의 데이터센터용 GPU를 갖춘 대규모 분산 시스템에서 학습되는데, GPT-4의 경우 모델을 학습하는 데 소모되는 비용은 약 1,400억 원에 육박하는 것으로 추산된다. 한국 연구진이 GPU 사용률을 높이고 학습 비용을 절감할 수 있는 최적의 병렬화 구성을 도출하도록 돕는 기술을 개발했다.

우리 대학 전기및전자공학부 유민수 교수 연구팀은 삼성전자 삼성종합기술원과 공동연구를 통해, 대규모 분산 시스템에서 대형 언어 모델(LLM)의 학습 시간을 예측하고 최적화할 수 있는 시뮬레이션 프레임워크(이하 vTrain)를 개발했다고 13일 밝혔다.

대형 언어 모델 학습 효율을 높이려면 최적의 분산 학습 전략을 찾는 것이 필수적이다. 그러나 가능한 전략의 경우의 수가 방대할 뿐 아니라 실제 환경에서 각 전략의 성능을 테스트하는 데는 막대한 비용과 시간이 들어간다.

이에 따라 현재 대형 언어 모델을 학습하는 기업들은 일부 경험적으로 검증된 소수의 전략만을 사용하고 있다. 이는 GPU 활용의 비효율성과 불필요한 비용 증가를 초래하지만, 대규모 시스템을 위한 시뮬레이션 기술이 부족해 기업들이 문제를 효과적으로 해결하지 못하고 있는 상황이다.

이에 유민수 교수 연구팀은 vTrain을 개발해 대형 언어 모델의 학습 시간을 정확히 예측하고, 다양한 분산 병렬화 전략을 빠르게 탐색할 수 있도록 했다.

연구팀은 실제 다중 GPU 환경에서 다양한 대형 언어 모델 학습 시간 실측값과 vTrain의 예측값을 비교한 결과, 단일 노드에서 평균 절대 오차(MAPE) 8.37%, 다중 노드에서 14.73%의 정확도로 학습 시간을 예측할 수 있음을 검증했다.

연구팀은 삼성전자 삼성종합기술원와 공동연구를 진행하여 vTrain 프레임워크와 1,500개 이상의 실제 학습 시간 측정 데이터를 오픈소스로 공개(https://github.com/VIA-Research/vTrain)하여 AI 연구자와 기업이 이를 자유롭게 활용할 수 있도록 했다.

유민수 교수는 “vTrain은 프로파일링 기반 시뮬레이션 기법으로 기존 경험적 방식 대비 GPU 사용률을 높이고 학습 비용을 절감할 수 있는 학습 전략을 탐색하였으며 오픈소스를 공개하였다. 이를 통해 기업들은 초거대 인공지능 모델 학습 비용을 효율적으로 절감할 것이다”라고 말했다.

이 연구 결과는 방제현 박사과정이 제1 저자로 참여하였고 컴퓨터 아키텍처 분야의 최우수 학술대회 중 하나인 미국 전기전자공학회(IEEE)·전산공학회(ACM) 공동 마이크로아키텍처 국제 학술대회(MICRO)에서 지난 11월 발표됐다. (논문제목: vTrain: A Simulation Framework for Evaluating Cost-Effective and Compute-Optimal Large Language Model Training, https://doi.org/10.1109/MICRO61859.2024.00021)

이번 연구는 정부(과학기술정보통신부)의 재원으로 한국연구재단, 정보통신기획평가원, 그리고 삼성전자의 지원을 받아 수행되었으며, 과학기술정보통신부 및 정보통신기획평가원의 SW컴퓨팅산업원천기술개발(SW스타랩) 사업으로 연구개발한 결과물이다.

챗GPT 등 대형 AI모델 학습 최적화 시뮬레이션 개발

최근 챗GPT, 딥시크(DeepSeek) 등 초거대 인공지능(AI) 모델이 다양한 분야에서 활용되며 주목받고 있다. 이러한 대형 언어 모델은 수만 개의 데이터센터용 GPU를 갖춘 대규모 분산 시스템에서 학습되는데, GPT-4의 경우 모델을 학습하는 데 소모되는 비용은 약 1,400억 원에 육박하는 것으로 추산된다. 한국 연구진이 GPU 사용률을 높이고 학습 비용을 절감할 수 있는 최적의 병렬화 구성을 도출하도록 돕는 기술을 개발했다.

우리 대학 전기및전자공학부 유민수 교수 연구팀은 삼성전자 삼성종합기술원과 공동연구를 통해, 대규모 분산 시스템에서 대형 언어 모델(LLM)의 학습 시간을 예측하고 최적화할 수 있는 시뮬레이션 프레임워크(이하 vTrain)를 개발했다고 13일 밝혔다.

대형 언어 모델 학습 효율을 높이려면 최적의 분산 학습 전략을 찾는 것이 필수적이다. 그러나 가능한 전략의 경우의 수가 방대할 뿐 아니라 실제 환경에서 각 전략의 성능을 테스트하는 데는 막대한 비용과 시간이 들어간다.

이에 따라 현재 대형 언어 모델을 학습하는 기업들은 일부 경험적으로 검증된 소수의 전략만을 사용하고 있다. 이는 GPU 활용의 비효율성과 불필요한 비용 증가를 초래하지만, 대규모 시스템을 위한 시뮬레이션 기술이 부족해 기업들이 문제를 효과적으로 해결하지 못하고 있는 상황이다.

이에 유민수 교수 연구팀은 vTrain을 개발해 대형 언어 모델의 학습 시간을 정확히 예측하고, 다양한 분산 병렬화 전략을 빠르게 탐색할 수 있도록 했다.

연구팀은 실제 다중 GPU 환경에서 다양한 대형 언어 모델 학습 시간 실측값과 vTrain의 예측값을 비교한 결과, 단일 노드에서 평균 절대 오차(MAPE) 8.37%, 다중 노드에서 14.73%의 정확도로 학습 시간을 예측할 수 있음을 검증했다.

연구팀은 삼성전자 삼성종합기술원와 공동연구를 진행하여 vTrain 프레임워크와 1,500개 이상의 실제 학습 시간 측정 데이터를 오픈소스로 공개(https://github.com/VIA-Research/vTrain)하여 AI 연구자와 기업이 이를 자유롭게 활용할 수 있도록 했다.

유민수 교수는 “vTrain은 프로파일링 기반 시뮬레이션 기법으로 기존 경험적 방식 대비 GPU 사용률을 높이고 학습 비용을 절감할 수 있는 학습 전략을 탐색하였으며 오픈소스를 공개하였다. 이를 통해 기업들은 초거대 인공지능 모델 학습 비용을 효율적으로 절감할 것이다”라고 말했다.

이 연구 결과는 방제현 박사과정이 제1 저자로 참여하였고 컴퓨터 아키텍처 분야의 최우수 학술대회 중 하나인 미국 전기전자공학회(IEEE)·전산공학회(ACM) 공동 마이크로아키텍처 국제 학술대회(MICRO)에서 지난 11월 발표됐다. (논문제목: vTrain: A Simulation Framework for Evaluating Cost-Effective and Compute-Optimal Large Language Model Training, https://doi.org/10.1109/MICRO61859.2024.00021)

이번 연구는 정부(과학기술정보통신부)의 재원으로 한국연구재단, 정보통신기획평가원, 그리고 삼성전자의 지원을 받아 수행되었으며, 과학기술정보통신부 및 정보통신기획평가원의 SW컴퓨팅산업원천기술개발(SW스타랩) 사업으로 연구개발한 결과물이다.

2025.03.13

조회수 4178

-

인간의 인지 방식과 유사한 AI 모델 개발

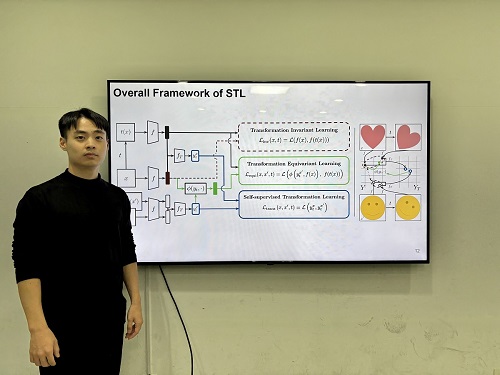

우리 연구진이 인간의 인지 방식을 모방해 이미지 변화를 이해하고, 시각적 일반화와 특정성을 동시에 확보하는 인공지능 기술을 개발했다. 이 기술은 의료 영상 분석, 자율주행, 로보틱스 등 다양한 분야에서 이미지를 이해하여 객체를 분류, 탐지하는 데 활용될 전망이다.

우리 대학 전기및전자공학부 김준모 교수 연구팀이 변환 레이블(transformational labels) 없이도 스스로 변환 민감 특징(transformation-sensitive features)을 학습할 수 있는 새로운 시각 인공지능 모델 STL(Self-supervised Transformation Learning)을 개발했다고 13일 밝혔다.

연구팀이 개발한 시각 인공지능 모델 STL은 스스로 이미지의 변환을 학습하여, 이미지 변환의 종류를 인간이 직접 알려주면서 학습하는 기존 방법들보다 높은 시각 정보 이해 능력을 보였다. 특히, 기존 방법론들을 통해 학습한 모델이 이해할 수 없는 세부적인 특징까지도 학습하여 기존 방법 대비 최대 42% 우수한 성능을 보여줬다.

컴퓨터 비전에서 이미지 변환을 통한 데이터 증강을 활용해 강건한 시각 표현을 학습하는 방식은 일반화 능력을 갖추는 데 효과적이지만, 변환에 따른 시각적 세부 사항을 무시하는 경향이 있어 범용 시각 인공지능 모델로서 한계가 있다.

연구팀이 제안한 STL은 변환 라벨 없이 변환 정보를 학습할 수 있도록 설계된 새로운 학습 기법으로, 라벨 없이 변환 민감 특징을 학습할 수 있다. 또한, 기존 학습 방법 대비 학습 복잡도를 유지한 채로 효율적인 최적화할 수 있는 방법을 제안했다.

실험 결과, STL은 정확하게 객체를 분류하고 탐지 실험에서 가장 낮은 오류율을 기록했다. 또한, STL이 생성한 표현 공간은 변환의 강도와 유형에 따라 명확히 군집화되어 변환 간 관계를 잘 반영하는 것으로 나타났다.

김준모 교수는 "이번에 개발한 STL은 복잡한 변환 패턴을 학습하고 이를 표현 공간에서 효과적으로 반영하는 능력을 통해 변환 민감 특징 학습의 새로운 가능성을 제시했다”며, "라벨 없이도 변환 정보를 학습할 수 있는 기술은 다양한 AI 응용 분야에서 핵심적인 역할을 할 것”이라고 말했다.

우리 대학 전기및전자공학부 유재명 박사과정이 제1 저자로 참여한 이번 연구는 최고 권위 국제 학술지 ‘신경정보처리시스템학회(NeurIPS) 2024’에서 올 12월 발표될 예정이다.(논문명: Self-supervised Transformation Learning for Equivariant Representations)

한편 이번 연구는 이 논문은 2024년도 정부(과학기술정보통신부)의 재원으로 정보통신기획평가원의 지원을 받아 수행된 연구 성과물(No.RS-2024-00439020, 지속가능한 실시간 멀티모달 인터렉티브 생성 AI 개발, SW스타랩) 이다.

인간의 인지 방식과 유사한 AI 모델 개발

우리 연구진이 인간의 인지 방식을 모방해 이미지 변화를 이해하고, 시각적 일반화와 특정성을 동시에 확보하는 인공지능 기술을 개발했다. 이 기술은 의료 영상 분석, 자율주행, 로보틱스 등 다양한 분야에서 이미지를 이해하여 객체를 분류, 탐지하는 데 활용될 전망이다.

우리 대학 전기및전자공학부 김준모 교수 연구팀이 변환 레이블(transformational labels) 없이도 스스로 변환 민감 특징(transformation-sensitive features)을 학습할 수 있는 새로운 시각 인공지능 모델 STL(Self-supervised Transformation Learning)을 개발했다고 13일 밝혔다.

연구팀이 개발한 시각 인공지능 모델 STL은 스스로 이미지의 변환을 학습하여, 이미지 변환의 종류를 인간이 직접 알려주면서 학습하는 기존 방법들보다 높은 시각 정보 이해 능력을 보였다. 특히, 기존 방법론들을 통해 학습한 모델이 이해할 수 없는 세부적인 특징까지도 학습하여 기존 방법 대비 최대 42% 우수한 성능을 보여줬다.

컴퓨터 비전에서 이미지 변환을 통한 데이터 증강을 활용해 강건한 시각 표현을 학습하는 방식은 일반화 능력을 갖추는 데 효과적이지만, 변환에 따른 시각적 세부 사항을 무시하는 경향이 있어 범용 시각 인공지능 모델로서 한계가 있다.

연구팀이 제안한 STL은 변환 라벨 없이 변환 정보를 학습할 수 있도록 설계된 새로운 학습 기법으로, 라벨 없이 변환 민감 특징을 학습할 수 있다. 또한, 기존 학습 방법 대비 학습 복잡도를 유지한 채로 효율적인 최적화할 수 있는 방법을 제안했다.

실험 결과, STL은 정확하게 객체를 분류하고 탐지 실험에서 가장 낮은 오류율을 기록했다. 또한, STL이 생성한 표현 공간은 변환의 강도와 유형에 따라 명확히 군집화되어 변환 간 관계를 잘 반영하는 것으로 나타났다.

김준모 교수는 "이번에 개발한 STL은 복잡한 변환 패턴을 학습하고 이를 표현 공간에서 효과적으로 반영하는 능력을 통해 변환 민감 특징 학습의 새로운 가능성을 제시했다”며, "라벨 없이도 변환 정보를 학습할 수 있는 기술은 다양한 AI 응용 분야에서 핵심적인 역할을 할 것”이라고 말했다.

우리 대학 전기및전자공학부 유재명 박사과정이 제1 저자로 참여한 이번 연구는 최고 권위 국제 학술지 ‘신경정보처리시스템학회(NeurIPS) 2024’에서 올 12월 발표될 예정이다.(논문명: Self-supervised Transformation Learning for Equivariant Representations)

한편 이번 연구는 이 논문은 2024년도 정부(과학기술정보통신부)의 재원으로 정보통신기획평가원의 지원을 받아 수행된 연구 성과물(No.RS-2024-00439020, 지속가능한 실시간 멀티모달 인터렉티브 생성 AI 개발, SW스타랩) 이다.

2024.12.15

조회수 5191

GPU 한 대로 95배 빠르게 그래프 분석 AI 'FlexGNN' 개발

텍스트 기반 대규모 언어 모델(LLM)인 ChatGPT 등과 함께, 산업 현장에서는 금융 거래, 주식, SNS, 환자기록, 등 비정형 데이터를 그래프 형태로 분석하는 GNN(Graph Neural Network) 기반의 그래프 AI 모델이 적극 활용되고 있다. 하지만 전체 그래프를 한 번에 학습(풀 그래프 학습)하는데 막대한 메모리와 GPU 서버가 필요하다는 한계점이 있다. KAIST 연구진이 단 한 대의 GPU 서버만으로도 대규모 GNN 모델을 최고속 학습할 수 있는 세계 최고 성능의 소프트웨어 기술 개발에 성공했다.

우리 대학 전산학부 김민수 교수 연구팀이 여러 대의 GPU 서버를 활용하는 기존 방식과 달리 한 대의 GPU 서버에서 대규모 풀(full) 그래프 AI 모델을 빠르게 학습하고 추론할 수 있는 GNN 시스템 ‘FlexGNN(플렉스지엔엔)’을 개발했다고 13일 밝혔다. FlexGNN은 기존 기술 대비 학습 속도를 최대 95배 향상한다.

최근 기후, 금융, 의료, 제약, 제조, 유통 등 다양한 분야에서는 데이터를 정점과 간선으로 구성된 그래프 형태로 변환해 분석 및 예측하는 사례가 증가하고 있다.

전체 그래프를 모두 학습에 활용하는 풀 그래프 방식이 더욱 우수한 정확도를 보이지만, 학습 과정에서 대규모의 중간 데이터(intermediate data)가 발생해 메모리 부족 현상이 빈번히 발생하고, 여러 서버 간의 데이터 통신으로 인해 학습 시간이 길어지는 한계가 있었다.

연구팀이 개발한 FlexGNN은 이러한 문제를 극복하기 위해 여러 대의 GPU 서버 대신 단일 GPU 서버에서 SSD(솔리드 스테이트 드라이브)와 메인 메모리를 활용한 최적의 AI 모델 학습을 수행한다.

특히 데이터베이스 시스템의 질을 최적화시키는 AI 퀴리 최적화 학습을 통해 GPU-메인 메모리-SSD 계층 간 모델 파라미터, 학습 데이터, 중간 데이터를 최적의 시점과 방식으로 계산을 시키는 새로운 학습 최적화 기술을 개발했다.

이를 통해 FlexGNN은 데이터 크기, 모델 규모, GPU 메모리 등 가용 자원 상황에 따라 유연하게 최적의 학습 실행 계획을 생성해 높은 자원 효율성과 학습 속도를 구현한다.

그 결과, 메인 메모리 용량을 훨씬 초과하는 데이터에 대해서도 GNN 모델을 학습하며, 단일 GPU 서버에서도 최대 95배 빠르게 학습이 가능해졌다. 특히 기후 예측 등에서 슈퍼컴퓨터보다 정밀한 분석이 가능한 풀 그래프 AI 구현이 현실화됐다.

우리 대학 김민수 교수는 “날씨 예측과 신소재 발견 등 복잡한 문제를 해결하는데 풀 그래프 GNN 모델이 활발히 활용되면서 관련 기술의 중요성이 점점 높아지고 있다”며 “FlexGNN이 그동안 어려움으로 남아 있던 그래프 AI 모델의 학습 규모와 속도 문제를 획기적으로 해결한 만큼, 다양한 산업 분야에 널리 활용되기를 기대한다”고 밝혔다.

이번 연구는 전산학부 배정민 박사과정이 제1 저자로, 김민수 교수창업기업인 (주)그래파이의 한동형 CTO가 제2 저자로 참여했으며, 김 교수가 교신저자를 맡았다.

연구 결과는 세계적 권위의 데이터마이닝 학술대회인 ‘ACM KDD’에서 지난 8월 5일에 발표됐다. FlexGNN 기술은 향후 (주)그래파이의 그래프 DB 솔루션인 그래프온(GraphOn)에도 적용될 예정이다.

※ 논문제목: FlexGNN: A High-Performance, Large-Scale Full-Graph GNN System with Best-Effort Training Plan Optimization

※ DOI: https://doi.org/10.1145/3711896.3736964

한편, 이번 연구는 과기정통부 IITP SW스타랩과 IITP-ITRC, 그리고 한국연구재단 중견과제의 지원을 받아 수행됐다.

2025.08.13 조회수 193

GPU 한 대로 95배 빠르게 그래프 분석 AI 'FlexGNN' 개발

텍스트 기반 대규모 언어 모델(LLM)인 ChatGPT 등과 함께, 산업 현장에서는 금융 거래, 주식, SNS, 환자기록, 등 비정형 데이터를 그래프 형태로 분석하는 GNN(Graph Neural Network) 기반의 그래프 AI 모델이 적극 활용되고 있다. 하지만 전체 그래프를 한 번에 학습(풀 그래프 학습)하는데 막대한 메모리와 GPU 서버가 필요하다는 한계점이 있다. KAIST 연구진이 단 한 대의 GPU 서버만으로도 대규모 GNN 모델을 최고속 학습할 수 있는 세계 최고 성능의 소프트웨어 기술 개발에 성공했다.

우리 대학 전산학부 김민수 교수 연구팀이 여러 대의 GPU 서버를 활용하는 기존 방식과 달리 한 대의 GPU 서버에서 대규모 풀(full) 그래프 AI 모델을 빠르게 학습하고 추론할 수 있는 GNN 시스템 ‘FlexGNN(플렉스지엔엔)’을 개발했다고 13일 밝혔다. FlexGNN은 기존 기술 대비 학습 속도를 최대 95배 향상한다.

최근 기후, 금융, 의료, 제약, 제조, 유통 등 다양한 분야에서는 데이터를 정점과 간선으로 구성된 그래프 형태로 변환해 분석 및 예측하는 사례가 증가하고 있다.

전체 그래프를 모두 학습에 활용하는 풀 그래프 방식이 더욱 우수한 정확도를 보이지만, 학습 과정에서 대규모의 중간 데이터(intermediate data)가 발생해 메모리 부족 현상이 빈번히 발생하고, 여러 서버 간의 데이터 통신으로 인해 학습 시간이 길어지는 한계가 있었다.

연구팀이 개발한 FlexGNN은 이러한 문제를 극복하기 위해 여러 대의 GPU 서버 대신 단일 GPU 서버에서 SSD(솔리드 스테이트 드라이브)와 메인 메모리를 활용한 최적의 AI 모델 학습을 수행한다.

특히 데이터베이스 시스템의 질을 최적화시키는 AI 퀴리 최적화 학습을 통해 GPU-메인 메모리-SSD 계층 간 모델 파라미터, 학습 데이터, 중간 데이터를 최적의 시점과 방식으로 계산을 시키는 새로운 학습 최적화 기술을 개발했다.

이를 통해 FlexGNN은 데이터 크기, 모델 규모, GPU 메모리 등 가용 자원 상황에 따라 유연하게 최적의 학습 실행 계획을 생성해 높은 자원 효율성과 학습 속도를 구현한다.

그 결과, 메인 메모리 용량을 훨씬 초과하는 데이터에 대해서도 GNN 모델을 학습하며, 단일 GPU 서버에서도 최대 95배 빠르게 학습이 가능해졌다. 특히 기후 예측 등에서 슈퍼컴퓨터보다 정밀한 분석이 가능한 풀 그래프 AI 구현이 현실화됐다.

우리 대학 김민수 교수는 “날씨 예측과 신소재 발견 등 복잡한 문제를 해결하는데 풀 그래프 GNN 모델이 활발히 활용되면서 관련 기술의 중요성이 점점 높아지고 있다”며 “FlexGNN이 그동안 어려움으로 남아 있던 그래프 AI 모델의 학습 규모와 속도 문제를 획기적으로 해결한 만큼, 다양한 산업 분야에 널리 활용되기를 기대한다”고 밝혔다.

이번 연구는 전산학부 배정민 박사과정이 제1 저자로, 김민수 교수창업기업인 (주)그래파이의 한동형 CTO가 제2 저자로 참여했으며, 김 교수가 교신저자를 맡았다.

연구 결과는 세계적 권위의 데이터마이닝 학술대회인 ‘ACM KDD’에서 지난 8월 5일에 발표됐다. FlexGNN 기술은 향후 (주)그래파이의 그래프 DB 솔루션인 그래프온(GraphOn)에도 적용될 예정이다.

※ 논문제목: FlexGNN: A High-Performance, Large-Scale Full-Graph GNN System with Best-Effort Training Plan Optimization

※ DOI: https://doi.org/10.1145/3711896.3736964

한편, 이번 연구는 과기정통부 IITP SW스타랩과 IITP-ITRC, 그리고 한국연구재단 중견과제의 지원을 받아 수행됐다.

2025.08.13 조회수 193 챗GPT 등 대형 AI모델 학습 최적화 시뮬레이션 개발

최근 챗GPT, 딥시크(DeepSeek) 등 초거대 인공지능(AI) 모델이 다양한 분야에서 활용되며 주목받고 있다. 이러한 대형 언어 모델은 수만 개의 데이터센터용 GPU를 갖춘 대규모 분산 시스템에서 학습되는데, GPT-4의 경우 모델을 학습하는 데 소모되는 비용은 약 1,400억 원에 육박하는 것으로 추산된다. 한국 연구진이 GPU 사용률을 높이고 학습 비용을 절감할 수 있는 최적의 병렬화 구성을 도출하도록 돕는 기술을 개발했다.

우리 대학 전기및전자공학부 유민수 교수 연구팀은 삼성전자 삼성종합기술원과 공동연구를 통해, 대규모 분산 시스템에서 대형 언어 모델(LLM)의 학습 시간을 예측하고 최적화할 수 있는 시뮬레이션 프레임워크(이하 vTrain)를 개발했다고 13일 밝혔다.

대형 언어 모델 학습 효율을 높이려면 최적의 분산 학습 전략을 찾는 것이 필수적이다. 그러나 가능한 전략의 경우의 수가 방대할 뿐 아니라 실제 환경에서 각 전략의 성능을 테스트하는 데는 막대한 비용과 시간이 들어간다.

이에 따라 현재 대형 언어 모델을 학습하는 기업들은 일부 경험적으로 검증된 소수의 전략만을 사용하고 있다. 이는 GPU 활용의 비효율성과 불필요한 비용 증가를 초래하지만, 대규모 시스템을 위한 시뮬레이션 기술이 부족해 기업들이 문제를 효과적으로 해결하지 못하고 있는 상황이다.

이에 유민수 교수 연구팀은 vTrain을 개발해 대형 언어 모델의 학습 시간을 정확히 예측하고, 다양한 분산 병렬화 전략을 빠르게 탐색할 수 있도록 했다.

연구팀은 실제 다중 GPU 환경에서 다양한 대형 언어 모델 학습 시간 실측값과 vTrain의 예측값을 비교한 결과, 단일 노드에서 평균 절대 오차(MAPE) 8.37%, 다중 노드에서 14.73%의 정확도로 학습 시간을 예측할 수 있음을 검증했다.

연구팀은 삼성전자 삼성종합기술원와 공동연구를 진행하여 vTrain 프레임워크와 1,500개 이상의 실제 학습 시간 측정 데이터를 오픈소스로 공개(https://github.com/VIA-Research/vTrain)하여 AI 연구자와 기업이 이를 자유롭게 활용할 수 있도록 했다.

유민수 교수는 “vTrain은 프로파일링 기반 시뮬레이션 기법으로 기존 경험적 방식 대비 GPU 사용률을 높이고 학습 비용을 절감할 수 있는 학습 전략을 탐색하였으며 오픈소스를 공개하였다. 이를 통해 기업들은 초거대 인공지능 모델 학습 비용을 효율적으로 절감할 것이다”라고 말했다.

이 연구 결과는 방제현 박사과정이 제1 저자로 참여하였고 컴퓨터 아키텍처 분야의 최우수 학술대회 중 하나인 미국 전기전자공학회(IEEE)·전산공학회(ACM) 공동 마이크로아키텍처 국제 학술대회(MICRO)에서 지난 11월 발표됐다. (논문제목: vTrain: A Simulation Framework for Evaluating Cost-Effective and Compute-Optimal Large Language Model Training, https://doi.org/10.1109/MICRO61859.2024.00021)

이번 연구는 정부(과학기술정보통신부)의 재원으로 한국연구재단, 정보통신기획평가원, 그리고 삼성전자의 지원을 받아 수행되었으며, 과학기술정보통신부 및 정보통신기획평가원의 SW컴퓨팅산업원천기술개발(SW스타랩) 사업으로 연구개발한 결과물이다.

2025.03.13 조회수 4178

챗GPT 등 대형 AI모델 학습 최적화 시뮬레이션 개발

최근 챗GPT, 딥시크(DeepSeek) 등 초거대 인공지능(AI) 모델이 다양한 분야에서 활용되며 주목받고 있다. 이러한 대형 언어 모델은 수만 개의 데이터센터용 GPU를 갖춘 대규모 분산 시스템에서 학습되는데, GPT-4의 경우 모델을 학습하는 데 소모되는 비용은 약 1,400억 원에 육박하는 것으로 추산된다. 한국 연구진이 GPU 사용률을 높이고 학습 비용을 절감할 수 있는 최적의 병렬화 구성을 도출하도록 돕는 기술을 개발했다.

우리 대학 전기및전자공학부 유민수 교수 연구팀은 삼성전자 삼성종합기술원과 공동연구를 통해, 대규모 분산 시스템에서 대형 언어 모델(LLM)의 학습 시간을 예측하고 최적화할 수 있는 시뮬레이션 프레임워크(이하 vTrain)를 개발했다고 13일 밝혔다.

대형 언어 모델 학습 효율을 높이려면 최적의 분산 학습 전략을 찾는 것이 필수적이다. 그러나 가능한 전략의 경우의 수가 방대할 뿐 아니라 실제 환경에서 각 전략의 성능을 테스트하는 데는 막대한 비용과 시간이 들어간다.

이에 따라 현재 대형 언어 모델을 학습하는 기업들은 일부 경험적으로 검증된 소수의 전략만을 사용하고 있다. 이는 GPU 활용의 비효율성과 불필요한 비용 증가를 초래하지만, 대규모 시스템을 위한 시뮬레이션 기술이 부족해 기업들이 문제를 효과적으로 해결하지 못하고 있는 상황이다.

이에 유민수 교수 연구팀은 vTrain을 개발해 대형 언어 모델의 학습 시간을 정확히 예측하고, 다양한 분산 병렬화 전략을 빠르게 탐색할 수 있도록 했다.

연구팀은 실제 다중 GPU 환경에서 다양한 대형 언어 모델 학습 시간 실측값과 vTrain의 예측값을 비교한 결과, 단일 노드에서 평균 절대 오차(MAPE) 8.37%, 다중 노드에서 14.73%의 정확도로 학습 시간을 예측할 수 있음을 검증했다.

연구팀은 삼성전자 삼성종합기술원와 공동연구를 진행하여 vTrain 프레임워크와 1,500개 이상의 실제 학습 시간 측정 데이터를 오픈소스로 공개(https://github.com/VIA-Research/vTrain)하여 AI 연구자와 기업이 이를 자유롭게 활용할 수 있도록 했다.

유민수 교수는 “vTrain은 프로파일링 기반 시뮬레이션 기법으로 기존 경험적 방식 대비 GPU 사용률을 높이고 학습 비용을 절감할 수 있는 학습 전략을 탐색하였으며 오픈소스를 공개하였다. 이를 통해 기업들은 초거대 인공지능 모델 학습 비용을 효율적으로 절감할 것이다”라고 말했다.

이 연구 결과는 방제현 박사과정이 제1 저자로 참여하였고 컴퓨터 아키텍처 분야의 최우수 학술대회 중 하나인 미국 전기전자공학회(IEEE)·전산공학회(ACM) 공동 마이크로아키텍처 국제 학술대회(MICRO)에서 지난 11월 발표됐다. (논문제목: vTrain: A Simulation Framework for Evaluating Cost-Effective and Compute-Optimal Large Language Model Training, https://doi.org/10.1109/MICRO61859.2024.00021)

이번 연구는 정부(과학기술정보통신부)의 재원으로 한국연구재단, 정보통신기획평가원, 그리고 삼성전자의 지원을 받아 수행되었으며, 과학기술정보통신부 및 정보통신기획평가원의 SW컴퓨팅산업원천기술개발(SW스타랩) 사업으로 연구개발한 결과물이다.

2025.03.13 조회수 4178 인간의 인지 방식과 유사한 AI 모델 개발

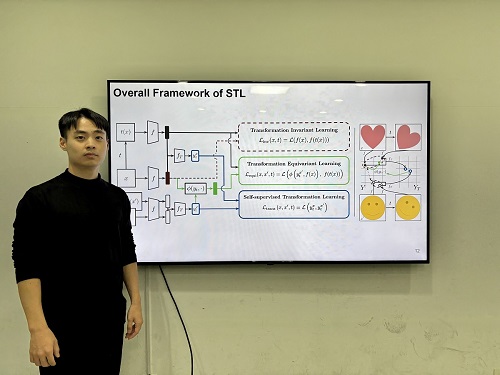

우리 연구진이 인간의 인지 방식을 모방해 이미지 변화를 이해하고, 시각적 일반화와 특정성을 동시에 확보하는 인공지능 기술을 개발했다. 이 기술은 의료 영상 분석, 자율주행, 로보틱스 등 다양한 분야에서 이미지를 이해하여 객체를 분류, 탐지하는 데 활용될 전망이다.

우리 대학 전기및전자공학부 김준모 교수 연구팀이 변환 레이블(transformational labels) 없이도 스스로 변환 민감 특징(transformation-sensitive features)을 학습할 수 있는 새로운 시각 인공지능 모델 STL(Self-supervised Transformation Learning)을 개발했다고 13일 밝혔다.

연구팀이 개발한 시각 인공지능 모델 STL은 스스로 이미지의 변환을 학습하여, 이미지 변환의 종류를 인간이 직접 알려주면서 학습하는 기존 방법들보다 높은 시각 정보 이해 능력을 보였다. 특히, 기존 방법론들을 통해 학습한 모델이 이해할 수 없는 세부적인 특징까지도 학습하여 기존 방법 대비 최대 42% 우수한 성능을 보여줬다.

컴퓨터 비전에서 이미지 변환을 통한 데이터 증강을 활용해 강건한 시각 표현을 학습하는 방식은 일반화 능력을 갖추는 데 효과적이지만, 변환에 따른 시각적 세부 사항을 무시하는 경향이 있어 범용 시각 인공지능 모델로서 한계가 있다.

연구팀이 제안한 STL은 변환 라벨 없이 변환 정보를 학습할 수 있도록 설계된 새로운 학습 기법으로, 라벨 없이 변환 민감 특징을 학습할 수 있다. 또한, 기존 학습 방법 대비 학습 복잡도를 유지한 채로 효율적인 최적화할 수 있는 방법을 제안했다.

실험 결과, STL은 정확하게 객체를 분류하고 탐지 실험에서 가장 낮은 오류율을 기록했다. 또한, STL이 생성한 표현 공간은 변환의 강도와 유형에 따라 명확히 군집화되어 변환 간 관계를 잘 반영하는 것으로 나타났다.

김준모 교수는 "이번에 개발한 STL은 복잡한 변환 패턴을 학습하고 이를 표현 공간에서 효과적으로 반영하는 능력을 통해 변환 민감 특징 학습의 새로운 가능성을 제시했다”며, "라벨 없이도 변환 정보를 학습할 수 있는 기술은 다양한 AI 응용 분야에서 핵심적인 역할을 할 것”이라고 말했다.

우리 대학 전기및전자공학부 유재명 박사과정이 제1 저자로 참여한 이번 연구는 최고 권위 국제 학술지 ‘신경정보처리시스템학회(NeurIPS) 2024’에서 올 12월 발표될 예정이다.(논문명: Self-supervised Transformation Learning for Equivariant Representations)

한편 이번 연구는 이 논문은 2024년도 정부(과학기술정보통신부)의 재원으로 정보통신기획평가원의 지원을 받아 수행된 연구 성과물(No.RS-2024-00439020, 지속가능한 실시간 멀티모달 인터렉티브 생성 AI 개발, SW스타랩) 이다.

2024.12.15 조회수 5191

인간의 인지 방식과 유사한 AI 모델 개발

우리 연구진이 인간의 인지 방식을 모방해 이미지 변화를 이해하고, 시각적 일반화와 특정성을 동시에 확보하는 인공지능 기술을 개발했다. 이 기술은 의료 영상 분석, 자율주행, 로보틱스 등 다양한 분야에서 이미지를 이해하여 객체를 분류, 탐지하는 데 활용될 전망이다.

우리 대학 전기및전자공학부 김준모 교수 연구팀이 변환 레이블(transformational labels) 없이도 스스로 변환 민감 특징(transformation-sensitive features)을 학습할 수 있는 새로운 시각 인공지능 모델 STL(Self-supervised Transformation Learning)을 개발했다고 13일 밝혔다.

연구팀이 개발한 시각 인공지능 모델 STL은 스스로 이미지의 변환을 학습하여, 이미지 변환의 종류를 인간이 직접 알려주면서 학습하는 기존 방법들보다 높은 시각 정보 이해 능력을 보였다. 특히, 기존 방법론들을 통해 학습한 모델이 이해할 수 없는 세부적인 특징까지도 학습하여 기존 방법 대비 최대 42% 우수한 성능을 보여줬다.

컴퓨터 비전에서 이미지 변환을 통한 데이터 증강을 활용해 강건한 시각 표현을 학습하는 방식은 일반화 능력을 갖추는 데 효과적이지만, 변환에 따른 시각적 세부 사항을 무시하는 경향이 있어 범용 시각 인공지능 모델로서 한계가 있다.

연구팀이 제안한 STL은 변환 라벨 없이 변환 정보를 학습할 수 있도록 설계된 새로운 학습 기법으로, 라벨 없이 변환 민감 특징을 학습할 수 있다. 또한, 기존 학습 방법 대비 학습 복잡도를 유지한 채로 효율적인 최적화할 수 있는 방법을 제안했다.

실험 결과, STL은 정확하게 객체를 분류하고 탐지 실험에서 가장 낮은 오류율을 기록했다. 또한, STL이 생성한 표현 공간은 변환의 강도와 유형에 따라 명확히 군집화되어 변환 간 관계를 잘 반영하는 것으로 나타났다.

김준모 교수는 "이번에 개발한 STL은 복잡한 변환 패턴을 학습하고 이를 표현 공간에서 효과적으로 반영하는 능력을 통해 변환 민감 특징 학습의 새로운 가능성을 제시했다”며, "라벨 없이도 변환 정보를 학습할 수 있는 기술은 다양한 AI 응용 분야에서 핵심적인 역할을 할 것”이라고 말했다.

우리 대학 전기및전자공학부 유재명 박사과정이 제1 저자로 참여한 이번 연구는 최고 권위 국제 학술지 ‘신경정보처리시스템학회(NeurIPS) 2024’에서 올 12월 발표될 예정이다.(논문명: Self-supervised Transformation Learning for Equivariant Representations)

한편 이번 연구는 이 논문은 2024년도 정부(과학기술정보통신부)의 재원으로 정보통신기획평가원의 지원을 받아 수행된 연구 성과물(No.RS-2024-00439020, 지속가능한 실시간 멀티모달 인터렉티브 생성 AI 개발, SW스타랩) 이다.

2024.12.15 조회수 5191